Realizar A/B testing en una campaña

El A/B testing consiste en comparar dos versiones (o más) de un elemento para evaluar empíricamente cuál obtiene mejores indicadores clave (convertir mejor, visitar o comprar más, etc.) a lo largo del tiempo. Para lograr este objectivo se define un diseño base y una o más variantes con las que se pretende obtener mejores resultados.

Antes de comenzar

Es importante tener en cuenta que al realizar A/B testing hay que seguir determinados lineamientos para obtener resultados válidos. De lo contrario, cualquier conclusión que se saque del experimento puede ser incorrecta.

Recomendaciones:

-

Cambios pequeños. Para que la medición sea efectiva, es necesario hacer variantes con cambios controlados. En los casos donde el diseño cambia completamente es difícil determinar cuál es la razón final que hace variar el indicador clave (puede ser el texto, el botón, el color o la imagen, por nombrar algunos ejemplos).

-

Testear por áreas de trabajo. Para poder hacer cambios controlados y medibles, es recomendable trabajar por áreas o temas como ilustran los siguientes ejemplos:

- Call to actions: cambiar el color del botón, el tamaño, la ubicación, etc.

- Fondos, colores e imágenes: variar la imagen de fondo, colores o el diseño del fondo.

- Textos: modificar los títulos, el texto, largo/corto, lenguaje, propuesta de valor, etc.

- Diagramación/Estilo: actualizar la organización de la información o detalles estéticos del diseño.

- Forms: usabilidad del formulario (extenso vs. breve, tipo de campos, etc.)

-

Volumen de datos. Tener mucha concurrencia de personas a lo largo del tiempo para obtener la mayor cantidad de resultados para evaluar.

Se recomienda evitar:

-

Hacer múltiples cambios. Si desea evaluar mejoras en el Call to Action, no realice cambios en la imagen y diseño al mismo tiempo.

-

Comparar variantes en distintos períodos de tiempo. Debido a que el público puede mostrar un comportamiento distinto en un período de dos semanas, no muestre una variante la primera y otra la siguiente. Esto puede suceder, por ejemplo, cuando es principio de mes y los clientes por lo general no compran en esos días.

-

Conclusiones apresuradas. Es importante tener un volumen considerable de datos para obtener un resultado estadísticamente válido. De esta forma, si se repite el test usted tendrá una certeza razonable de que va a obtener el mismo resultado. Para evaluar este punto, le recomendamos realizar un cálculo en línea utilizando un simulador.

Configurar A/B Testing

Prisma Campaigns le permite realizar A/B testing y agregar multiples variantes en varios de los canales que se encuentran dentro de la campaña. Debajo se detallan instrucciones para configurar cada uno de ellos.

- Banners

- SMS

- Push notifications

Banners

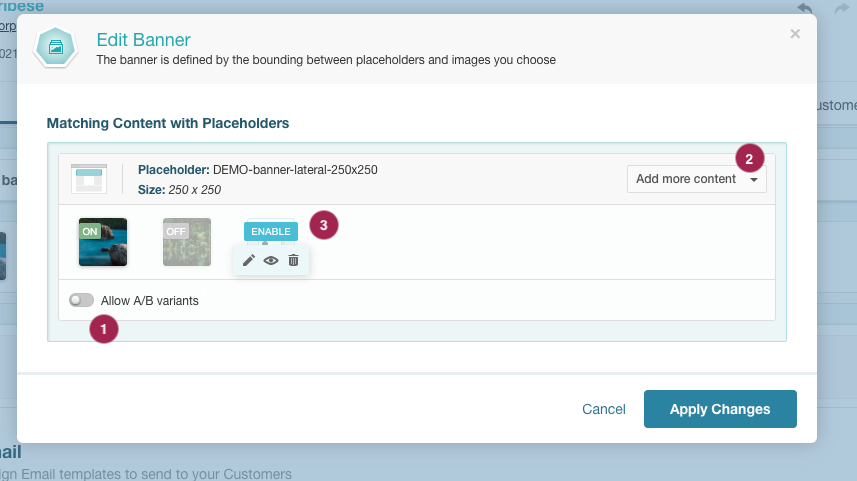

Para comenzar, diríjase a una campaña donde haya configurado el canal de banners previamente. Ingrese a la edición del contenido del banner y siga estos pasos para iniciar A/B testing, usando como referencia la imagen siguiente.

- Asegúrese de que el interruptor que permite mostrar más de una variante para el mismo placeholder esté activo.

- Expanda la lista y agregue más variantes (imagen, HTML, generada por Prisma-AI o elegida desde la biblioteca de medios) al banner. No es necesario que sean del mismo tipo, ya que se puede realizar A/B testing entre un banner imagen y otro HTML.

- Cada una de las versiones se pueden activar o desactivar, por lo que una vez subidas se deberán activar las que se deseen utilizar para A/B testing. Para ello, coloque el cursor encima de la imagen deseada y haga clic en el botón para activarla. La imagen mostrará la etiqueta ON/OFF de acuerdo a su estado.

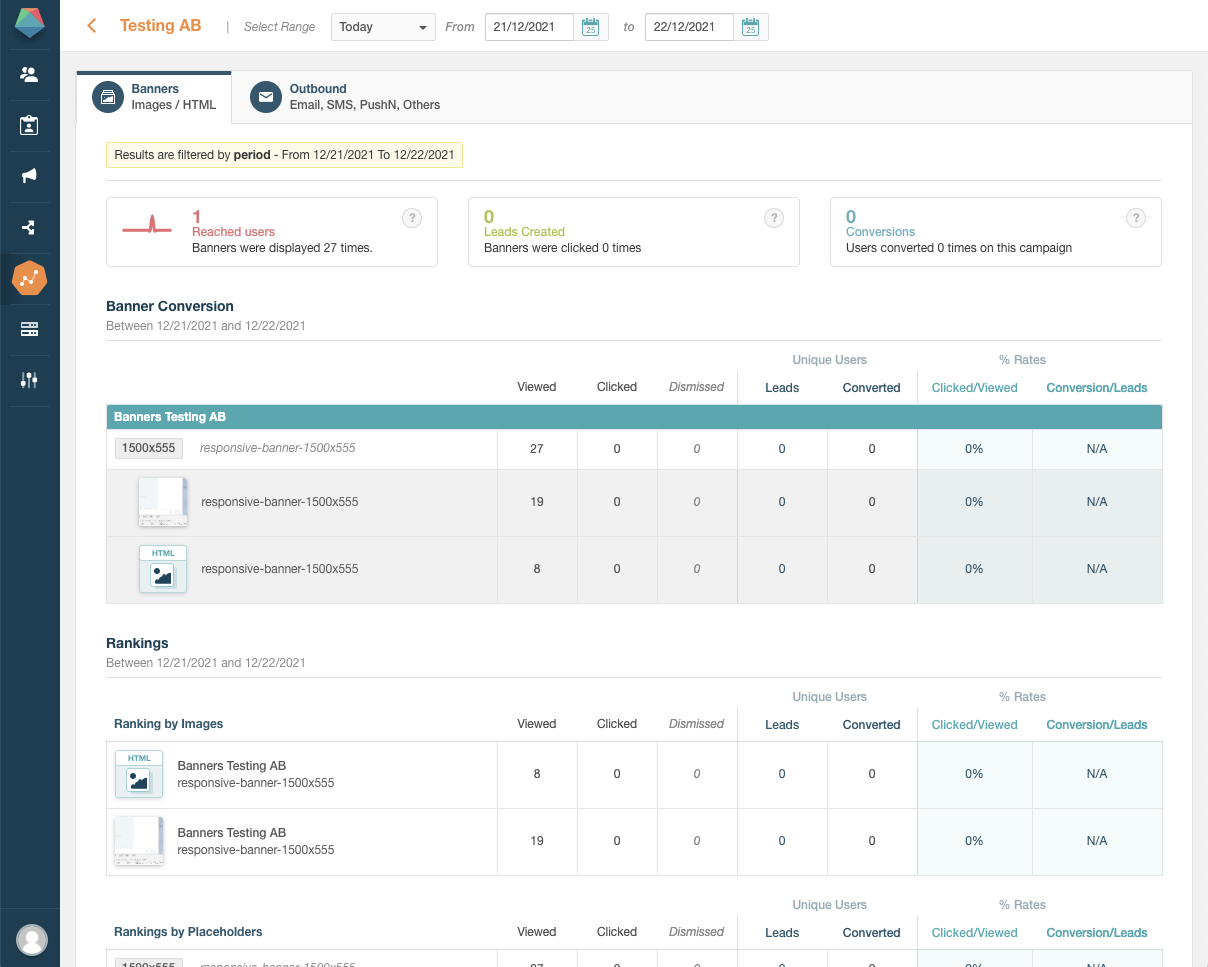

Una vez que haya ingresado la variante al banner y publicado la campaña, puede navegar al menú Analysis de esta y visualizar las variantes que fueron vistas. También podrá observar cómo ha sido la interacción en cada una, como se muestra en la imagen abajo.

Si no tiene una campaña con banners, refiérase a Agregar banners a una campaña.

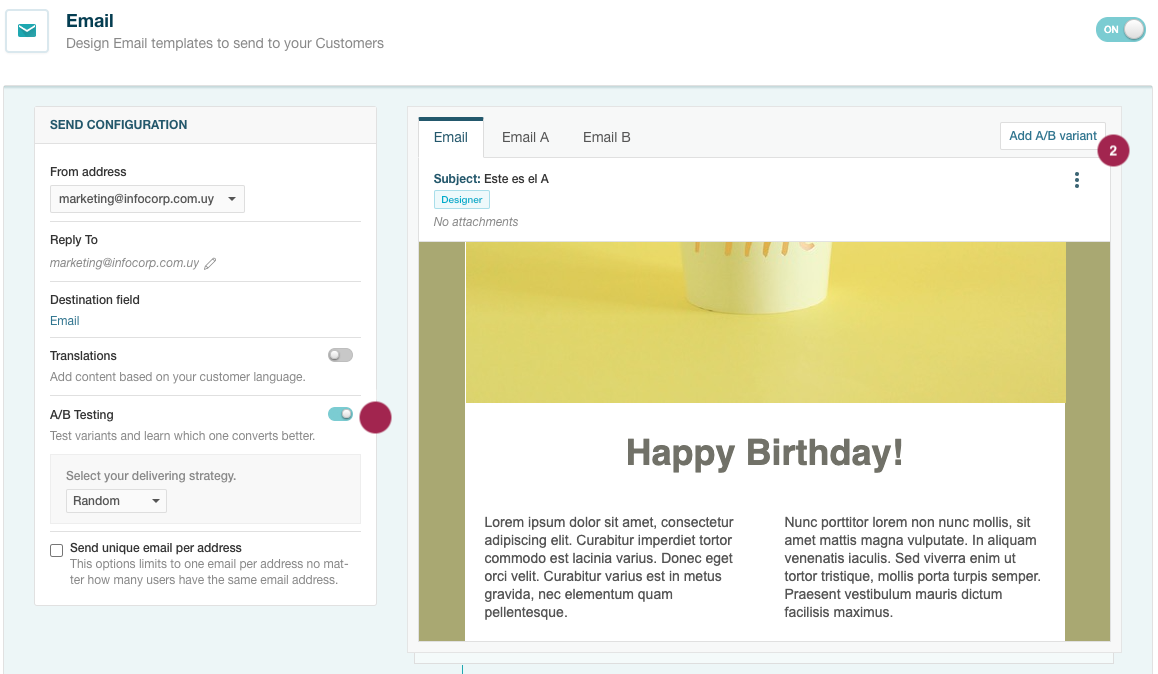

Si desea realizar A/B testing en el canal de email, ingrese a una campaña donde este se encuentre activo y utilice la imagen de abajo como referencia para continuar.

- Encender el interruptor para habilitar A/B Testing.

- Una vez habiltado, presione el botón Add A/B variant para añadir nuevas variantes.

- Las variantes agregadas aparecerán en solapas nuevas donde podrá visualizar y editar el contenido de cada una.

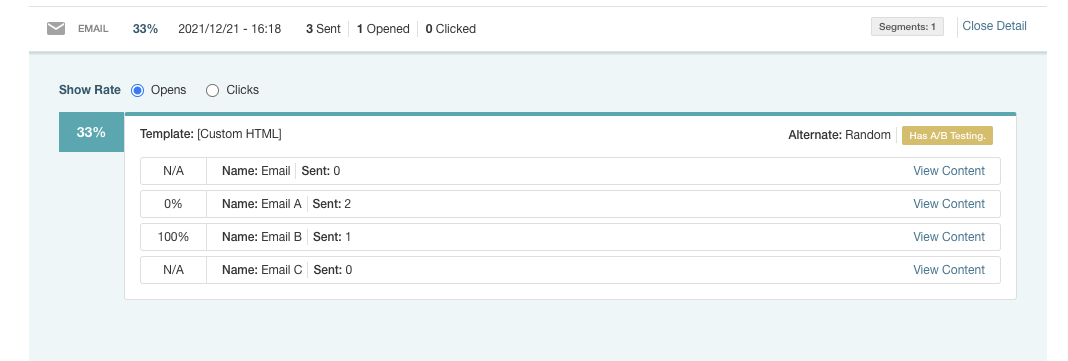

Una vez que haya agregado la variante al canal de email y publicado la campaña, necesitará agendar un envío en Orchestration. Después de que el mensaje haya sido visto por sus clientes, podrá empezar a visualizar en el apartado Outbound del menú Analysis los correos electrónicos que se entregaron y sus resultados.

Si no tiene una campaña con emails, puede dirigirse a Agregar Email a una campaña

SMS / Notificaciones Push

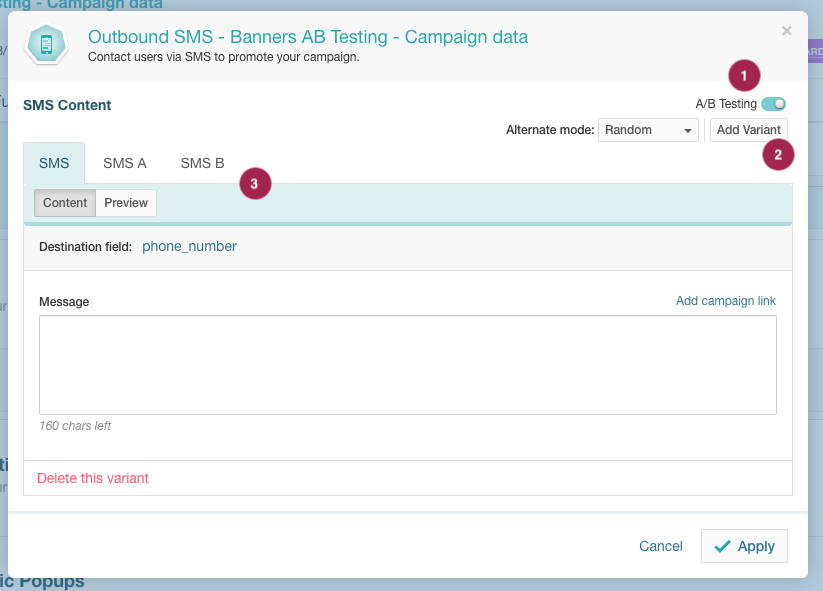

Para los canales de SMS y notificaciones push, el procedimiento para activar A/B testing y sus variantes es muy similar a los anteriores. En este caso emplearemos SMS como referencia, siguiendo los pasos detallados que se ilustran en la imagen.

- Encender el interruptor para habilitar A/B Testing.

- Una vez habiltado, presione el botón Add A/B variant para añadir nuevas variantes.

- Las variantes agregadas aparecerán en solapas nuevas donde podrá visualizar y editar el contenido de cada una.

Si no tiene una campaña con SMS o notificaciones push, puede dirigirse a Agregar SMS a una campaña o a Agregar Push Notifications dependiendo del caso.

Utilizar métricas clave para determinar el ganador de las pruebas A/B

En el caso de los canales outbound (Email, SMS y Push Notifications), Prisma Campaigns le permite medir automáticamente la variante ganadora en función de distintas métricas. Una vez determinada la variante con mejor rendimiento, el sistema enviará automáticamente el resto del envío utilizando esa versión ganadora.

Para realizar pruebas A/B, seleccione el botón A/B Testing al programar un blast. En la imagen de abajo, se puede observar un ejemplo para la campaña New Mortgages Offers y el canal Email.

El sistema enviará la comunicación al porcentaje de clientes especificado en Sample size y comparará el rendimiento de cada variante basándose en la métrica seleccionada a través de Winning measure (tasa de clic, conversión o apertura). Luego, enviará la que mejor rendimiento tenga al resto de los clientes como se menciona arriba.

Mediante Test duration puede establecer cuánto tiempo durará la prueba antes de que la versión ganadora se envíe automáticamente al resto de los clientes. En el ejemplo, la duración de la prueba está configurada en 3 días, lo que significa que la versión ganadora se enviará automáticamente después de este período.

También puede configurar la Starting date para especificar cuándo debe comenzar la prueba, ya sea seleccionando una fecha y hora específicas o programándola para que comience lo antes posible.

Artículos relacionados

- Personalizar textos de imágenes en banners HTML

- Recomendaciones para imágenes (tamaño/formato)

- Agregar banners en su campaña

- Agregar contenido a los correos electrónicos

- Agregar contenido para SMS

- Agregar notificaciones push

- Enviar un email recurrente

- Cómo evitar ser detectados como SPAM

- Distribuir envíos de campañas grandes en el tiempo

En esta página